以Python为例,手把手教你Spark应用开发的软件设计与实践

Apache Spark作为当今大数据领域最主流的计算框架之一,凭借其卓越的内存计算性能、丰富的API和高度的可扩展性,已成为企业级数据处理的基石。本文将以Python(PySpark)为例,系统地介绍Spark应用开发的软件设计理念与核心开发实践,旨在帮助开发者构建高效、健壮且易于维护的Spark应用程序。

第一部分:理解Spark核心架构与PySpark生态

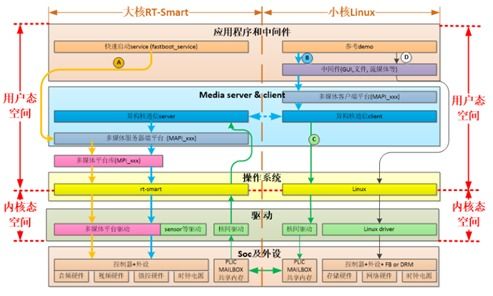

Spark应用开发的第一步是理解其核心架构。Spark采用主从(Master-Slave)架构,核心组件包括:

- Driver Program:即用户编写的Spark应用主程序(如我们的Python脚本),负责创建SparkContext,定义数据转换操作,并向集群管理器提交任务。

- Cluster Manager:负责资源的统一管理和调度,如Standalone、YARN或Kubernetes。

- Executor:运行在工作节点(Worker Node)上的进程,负责执行Driver分配的具体计算任务,并存储数据。

PySpark是Spark为Python开发者提供的API,它通过Py4J库在Python解释器和JVM Executor之间建立桥梁,使得我们可以用简洁的Python语法调用强大的Spark引擎。

第二部分:Spark应用开发的软件设计原则

开发一个生产级别的Spark应用,远不止于编写几行转换代码。良好的软件设计至关重要。

1. 模块化与可复用性

将业务逻辑分解为独立的、功能单一的模块。例如,可以将数据读取、数据清洗、特征工程、模型训练等步骤封装成不同的函数或类。这不仅使代码清晰,也便于单元测试和复用。

`python

# 示例:数据读取模块

def load_data(spark, path, format="parquet"):

return spark.read.format(format).load(path)

示例:数据清洗模块

def clean_data(df):

return df.dropDuplicates().fillna(0)

`

2. 配置化管理

避免将硬编码(如文件路径、数据库连接参数、并行度等)散落在代码各处。应使用配置文件(如JSON、YAML)或环境变量来管理这些参数,使应用更灵活,便于在不同环境(开发、测试、生产)间迁移。

3. 错误处理与健壮性

对潜在的错误(如数据缺失、连接失败)进行预判和处理。使用try-except块,并记录详细的日志,方便问题追踪。Spark应用本身也应配置合理的重试机制。

4. 性能考量设计

在设计阶段就需思考性能:

- 分区策略:根据数据量和操作类型,合理设置RDD/DataFrame的分区数(

repartition/coalesce),避免数据倾斜。

- 持久化策略:对于会被多次使用的中间结果,明智地使用

cache()或persist(),但要注意内存开销。

- 广播变量与累加器:对于只读的查找表,使用广播变量(

broadcast)能极大提高Join效率;使用累加器(accumulator)进行安全的状态聚合。

第三部分:PySpark应用开发实战流程

步骤1:环境搭建与初始化

`python

from pyspark.sql import SparkSession

创建SparkSession,这是所有Spark功能的统一入口

spark = SparkSession.builder \

.appName("MyFirstPySparkApp") \

.config("spark.executor.memory", "4g") \

.getOrCreate()

`

步骤2:数据抽象与操作

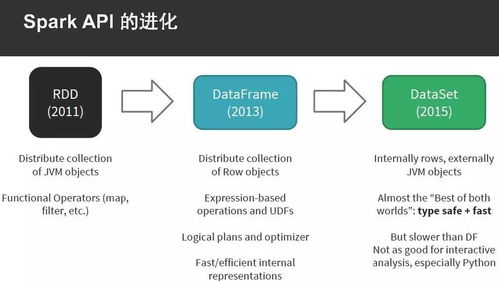

Spark的核心抽象是弹性分布式数据集(RDD)和更高级的DataFrame/Dataset。DataFrame API因其优化器和Tungsten执行引擎,是首选。

`python

# 读取数据,创建DataFrame

df = spark.read.csv("hdfs://path/to/data.csv", header=True, inferSchema=True)

使用DataFrame API进行转换操作(懒执行)

from pyspark.sql import functions as F

resultdf = df.filter(df["age"] > 18) \

.groupBy("department") \

.agg(F.avg("salary").alias("avgsalary"))

`

步骤3:应用提交与执行

开发完成后,使用spark-submit命令将应用提交到集群运行。

`bash

spark-submit \

--master yarn \

--deploy-mode cluster \

--executor-memory 2G \

mysparkapp.py

`

第四部分:测试与调试

- 单元测试:使用

pytest等框架,结合pyspark-testing等库,对数据转换函数进行本地小规模测试。 - 本地调试:在IDE中设置

master为local[*]进行本地运行和断点调试。 - 日志分析:充分利用Spark Web UI(4040端口)和Executor日志,分析任务执行时间、数据倾斜和GC情况。

第五部分:进阶设计模式

- Lambda架构:结合Spark Streaming(或Structured Streaming)处理实时数据流,与批处理层结果合并,提供全量+增量的数据视图。

- Medallion架构:在数据湖中组织数据为青铜层(原始数据)、白银层(清洗后)、黄金层(业务聚合),Spark是各层间转换的理想工具。

###

以Python进行Spark应用开发,关键在于将Python的灵活性与Spark的分布式计算能力相结合,并辅以严谨的软件工程设计思想。从理解架构出发,遵循模块化、可配置的设计原则,熟练运用DataFrame API,并时刻关注性能与健壮性,你就能设计并开发出高效、可靠的大数据应用,从容应对海量数据的挑战。

如若转载,请注明出处:http://www.tongyst.com/product/59.html

更新时间:2026-02-24 12:51:31